Гайд по SEO-продвижению сайта для начинающих

В прошлой статье мы рассмотрели в общих чертах пошаговый план продвижения коммерческих сайтов.

Будем считать, что вы ее уже прочитали и для вашего сайта были четко определены цели и решаемые задачи, выявлена целевая аудитория, назначены ключевые показатели эффективности вашего интернет-проекта и выбраны каналы для его продвижения.

Если одним из таких каналов было выбрано SEO, то вам имеет смысл ознакомиться и с этой публикацией, в которой мы попробуем залезть в шкуру Сео-специалиста, которому требуется продвинуть ваш сайт. Ну и постараемся понять, какие методы Сео продвижения стоит использовать, а так же раскроем некоторые завесы в работе поисковых систем.

P.S. Как бы я не хотел, но всего необходимого в одну (или даже несколько публикаций) не впихнешь (а дьявол, как говорится, кроется в деталях). В общем, есть вариант пройти онлайн-обучение по теме «SEO 2.0 от TexTerra«. Все же, за это время рассказать можно, наверное, все. Но это платно, само собой.

Легко ли сейчас быть Сео-шником

Сейчас работать в области SEO может далеко не каждый человек. Тут нужен особый склад характера, ибо существует целый ряд проблем, с которыми постоянно сталкивается подобный специалист:

Под какой поисковик продвигаться?

Кроме всех описанных выше сложностей, Сео-шники вынуждены при продвижении сайтов пытаться «услужить» по крайней мере двум хозяевам — Яндексу и Гуглу. А если брать в расчет и поиск Mail.ru, то трем.

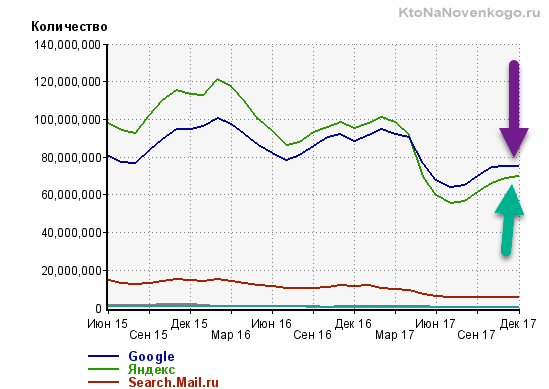

Если верить показаниям счетчика Ливинтернет, то в рунете (доменной зоне RU) сейчас наблюдается примерный паритет между Яндексом и Гуглом, а доля остальных поисковых систем исчезающе мала на их фоне (разве что только за исключение Майла, но там особая аудитория, которая в основном состоит из пользователей других сервисов этой корпорации).

Гул здорово подрос за последние годы, ибо раньше перевес у Яндекса был чуть ли не двухкратный. Секрет кроется в том, что сейчас идет тенденция к увеличению доли мобильного трафика (посетителей, заходящих на сайты со смартфонов и планшетов), а у Google тут огромное преимущество в виде собственной мобильной платформы Андроид и предустановленным там по умолчанию их поиском. Ход конем, что называется.

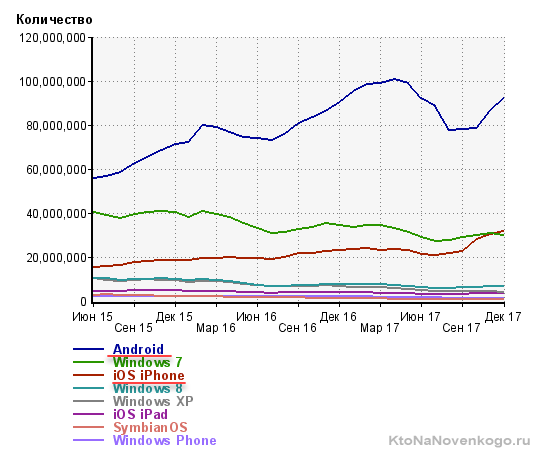

Как видно из данных того же Лайвинтернета, трафик с Андроида составляет больше трети от всего трафика рунета. Вы только вдумайтесь? А если брать в расчет и другие мобильные платформы, то число людей заходящих в сеть с мобильника уже превысило число тех, кто заходит с ПК или ноутбука. Дальше будет еще больший уход в мобильность и это опять же добавляет новых проблем сеошникам и маркетолагам, ибо существенно меняется поведение пользователей на сайте.

По-любому, от продвижения в Google (а уже тем более в Яндексе, ибо именно там сидит большая часть целевой аудитории по многим коммерческим тематикам) никто просто так отказаться не может, и практически все коммерческие сайты сейчас продвигаются под оба этих поисковика.

Ну, а если сайт будет ориентирован на буржунет, то там уже у Гугла вообще практически нет достойных конкурентов. На мировом уровне они даже не сопоставимы. Людские, финансовые и аппаратные ресурсы отличаются на порядок. А это влияет на то, как работают алгоритмы Google, и на то, как быстро он работает в целом.

Кроме этого, если опять вернуться к рунету, у Яндекса и Гугла существенно отличаются аудитории. Может вполне оказаться так, что вся ваша целевая аудитория пользуется только Гуглом (или только Яндексом).

Скажем так, в Яндексе больше чайников. И это вовсе не плохо, ибо из них получаются отличные покупатели, но если ваш товар или услуга ориентирована на чуть более продвинутых пользователей, то Google может стать для вас основным источником трафика. Какие-то глобальные исследования на этот счет вы вряд ли найдете в паблике, но я думаю, что начав развивать и продвигать сайт, вы быстро поймете, какая поисковая машина для вас является приоритетной.

Если говорить про поиск Майл.ру, то его доля в рунете составляет где-то около пяти процентов и обусловлена она прежде всего тем, что все сервисы Майла собирают огромную аудиторию в рунете (даже большую, чем все сервисы Яндекса). При этом у них периодически меняется поисковый движок. Они постоянно торгуются с Яндексом и Google о предоставлении им лучших условий, а когда договориться не удается, то временно используют свой собственный движок gogo.ru.

Белое, серое и черное SEO

Итак, SEO специалист должен будет всеми правдами и неправдами заставить упомянутые выше поисковые системы обратить внимание на продвигаемый им сайт (хотя бы в плане его полной индексации) и каким-то хитрым и непонятным способом принудить их его полюбить. И это все при том, что поисковики в своих лицензиях четко говорят, что при ранжировании и определении релевантности документов ими будут учитываться исключительно интересы пользователей поиска, а отнюдь не владельцев ресурсов.

Значит придется «хитрить» и зачастую идти на сознательное нарушение всех этих лицензий. В зависимости от степени ухищрений и глубины нарушений правил поисковых систем SEO продвижение можно разделить на три группы:

Однако, эти методы по-прежнему используются, и в выдаче Яндекса и Гугла можно по некоторым запросам наблюдать, например, засилье дорвеев, а в индексе поиска все так же имеется огромное количество ГС (смотрите непонятные вам термины в статье про то, как начать понимать Сеошников).

Перечислю примеры черного SEO без вдавания в конкретику, ибо никогда этим не занимался и заниматься не намерен:

Что нужно знать про работу поисковых систем

Однако для того, чтобы применять озвученные способы оптимизации, сеошник должен прежде всего понимать хотя бы общие принципы работы поисковых машин. И чем более рискованным SEO он собирается заниматься, тем более глубокими и детальными должны быть его познания.

Индексация сайтов

Работу начинает поисковый робот (бот), который представляет из себя обычный компьютер (сервер) с соответствующим ПО. Он обходит страницы с потенциальным наличием качественного и уникального контента, находит вебстраницу, определяет ее содержимое (объем, качество), и если она ему понравится, то он передает ее на следующий уровень, который можно определить, как поисковик.

В силу аппаратных ограничений роботы не снуют в интернете как заведенные, а руководствуются определенными принципами. Во-первых, они ходят на страницы, на которые проставлено много ссылок со страниц, которые уже есть в индексной базе. Во-вторых, частота повторного посещения не всегда высока и рассчитывается индивидуально.

У Яндекса можно выделить два типа роботов:

Поиск нужной информации в индексе

Поисковик представляет из себя опять же обычный сервер (что такое сервер), но с уже другим программным обеспечением. В его задачу входит обход найденных ботом страниц, скачивание их содержимого и дальнейшая его обработка (создание индекса).

Все помеченные поисковым роботом страницы выкачиваются (в виде исходных Html кодов), из них извлекается контент (текст заключенный в Html коде, который должен видеть посетитель) и производится его первичный разбор и анализ. Текст вебстраницы записывается в отдельный файл (условно) и туда же записываются все ссылки, найденные на странице (они потом отправляются поисковому роботу, чтобы он туда сходил тоже).

Из полученного текста удаляются все стоп-слова (союзы, предлоги) и знаки препинания. Полученный в результате набор слов разбивают на так называемые пассажи. По сути, это предложения, но с некоторыми допущениями. Пассажи, как и предложения, объединяются смысловой законченностью, но оперировать именно предложениями, при машинном анализе русского текста, практически не возможно (в силу его «великости и могучести»).

Т.е. анализ ведется не по физическим (изначально имеющимся в тексте) предложениям, а по вновь созданным (машинным), которые и назвали пассажами. Ну, а эти самые пассажи уже складываются в индексную базу и каждому пассажу присваивается свой вес, характеризующий его значимость внутри этого текста. Отчего может зависеть вес? Например, от того, насколько пассаж релевантен данному тексту, сколько раз он в нем повторяется и где внутри текста он расположен.

В результате формируется база данных (поисковый индекс), в которой каждая проиндексированная вебстраница представлена набором пассажей с удаленными шумовыми словами (бессмысленными, связующими, паразитными, повторениями). Именно по этой базе (индексу) ведется поиск.

Когда вам нужно будет вогнать в индекс новые страницы, появившиеся на сайте, то лучшим вариантом будут сервисы по привлечению быстробота (индексатора) поисковых систем. Среди них могу выделить два похожих — IndexGator и GetBot. Стоит это дело совсем не дорого, а эффект достаточно стабилен.

Определение релевантности и ранжирование результатов

На самом верхнем (к пользователям поисковых систем) находится поисковый сервис, который принимает запросы от пользователей, и на основании расчета релевантности и применения факторов ранжирования выбирает (из созданного на предыдущем этапе поисковиком обратного индекса) нужные вебстранички, которые потом и будут показаны пользователю в качестве выдачи (серпа).

Упрощенно это можно представить так, что посетитель Яндекса задает свой вопрос и поисковая система начинает искать в своей индексной базе страницы содержащие пассажи, максимально соответствующие этому запросу. Полученный список релевантных страниц теперь нужно будет ранжировать (расставить приоритеты), т.е. определить последовательность расположения этих вебстраниц в выдаче.

Первый принцип, который начал использоваться уже очень давно, называется индексом цитирования. В его базовой версии он учитывал число упоминаний данной страницы (число ведущих на нее ссылок). Об этой системе я довольно подробно писал в статье про то, что такое Тиц и Виц сайта в Яндексе. Недостаток такого подхода состоит в том, что учитывается только общее количество ссылок, но не их качество.

Поэтому далее был придуман взвешенный индекс цитирования, который учитывает авторитет и качество ссылающихся сайтов. Появляются так называемые веса (статические), которые передаются по ссылкам. В Google это индекс называется Пейдж Ранком, тулбарное значение которого раньше можно было узнать для любой страницы любого сайта (сейчас это дело прикрыли).

Взвешенный индекс цитирования можно описать, как коэффициент вероятности попадания посетителя на данную вебстраницу с любой другой страницы сети интернет. Другими словами, чем больше на эту страницу ссылок и чем больше среди ссылающихся ресурсов будет авторитетных, тем вероятнее будет посещение данной страницы и тем выше будет ее вес. Рассчитывается он с помощью формулы в несколько итераций. Формула эта периодически изменяется и дорабатывается.

Раньше мы могли наблюдать тулбарное значение ПейджРанка, которое обновлялось раз в несколько месяцев и было построено на основе логарифмической шкалы, когда реальная разница между весом страницы с ПР=1 и ПР=7 могла быть тысячекратной или даже больше. Подробности читайте в упомянутой чуть выше статье.

Также следует понимать, что то или иное значение ПейдРанка для вашей страницы на ее позицию в выдаче по тому или иному поисковому запросу прямого влияния оказывать не будет. Но в то же время алгоритм, заложенный в расчете ПР, используется при ранжировании страниц, а значит его нужно знать и понимать, чтобы в дальнейшем использовать для своей пользы.

Учет трансляции ссылочных весов при ранжировании

В схеме ПейджРанка (взвешенного индекса цитирования) имеется такое понятие, как передаваемый по ссылке вес.

Статический вес передаваемый по ссылкам

Передача веса является не совсем правильным термином, ибо вес не передается, а транслируется, т.е. донор (читайте статью про SEO термины) ничего не теряет при установке ссылки, но при этом акцептор получает по ней определенный статический вес. Под термином статический следует понимать то, что этот вес не зависит от того, что используется в качестве анкора ссылки.

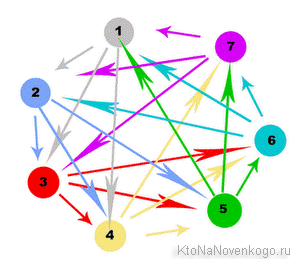

Сколько веса может передать та или иная вебстраница в интернете могут знать только алгоритмы поисковиков. Но доподлинно известно, что этот самый вес будет поровну поделен между всеми страницами-акцепторами, на который будут вести ссылки с этого донора. Исходя из этого принципа можно сделать массу выводов по внешней и внутренней перелинковки своего сайта.

Общий вывод по принципу трансляции весов — для того, чтобы прокачать какую-либо свою страницу, нужно получать на нее ссылки, желательно с авторитетных страниц. А как узнать, высок ли авторитет той или иной страницы в интернете? Правильно, нужно посмотреть на значение ПейджРанка для нее.

У Яндекса тоже имеется аналог пейджранка, который рассчитывается для всех страниц (ВИЦ), но узнать его значение сейчас не представляется возможным. Также у нашего поисковика имеется в арсенале еще и тематический индекс цитирования Тиц, при расчете которого прежде всего учитывается тематика ссылающихся ресурсов.

Измеряется он для всего сайта целиком. Для тематических ссылок (оценивается тематика по содержанию текста) применяется повышающий коэффициент, по сравнению с околотематическими и нетематическими, для которых может применяться серьезная сбавка передаваемого веса. Поэтому для наращивания Тиц важны ссылки не просто с авторитетных ресурсов, а желательно, чтобы они были близкой или совпадающей тематики с вашим сайтом. Напрямую на ранжирование он не влияет, но те же принципы используются для построения сайтов в выдаче.

Динамический вес, зависящий от текста ссылки (анкора)

До этого момента мы говорили только про статические веса. Однако, при расчете трансляции веса для любой ссылки, поисковые машины используют два типа весов. Первый — статический, о котором мы уже поговорили и который рассчитывается без учета текста ссылки (ее анкора). Второй — динамический (анкорный), который рассчитывается на основании нескольких параметров:

Чем более релевантны эти три составляющие, тем более высокий анкорный вес будет транслировать ссылка. Если у ссылки нет анкора (безанкорная), то динамический вес, передаваемый по ней, не рассчитывается вовсе. Статический вес передается всегда, если только сайт донор не находится под фильтром поисковых систем за продажу бэклинков.

Отсюда можно сделать очень важный вывод — любая ссылка, проставленная на ваш сайт, может быть ценна для вас двумя своими весами. Во-первых, мы нагоняем статический вес своей вебстраницы, что есть хорошо. Но если еще грамотно использовать анкор, то значимость этой же ссылки может быть увеличена в несколько раз.

Что нужно сделать, чтобы получить высокий анкорный вес? Попробуем расписать по пунктам:

Про использование в анкорах прямых и разбавленных вхождений ключевых слов вы можете почитать по приведенной чуть выше ссылке.

Источник: ktonanovenkogo.ru